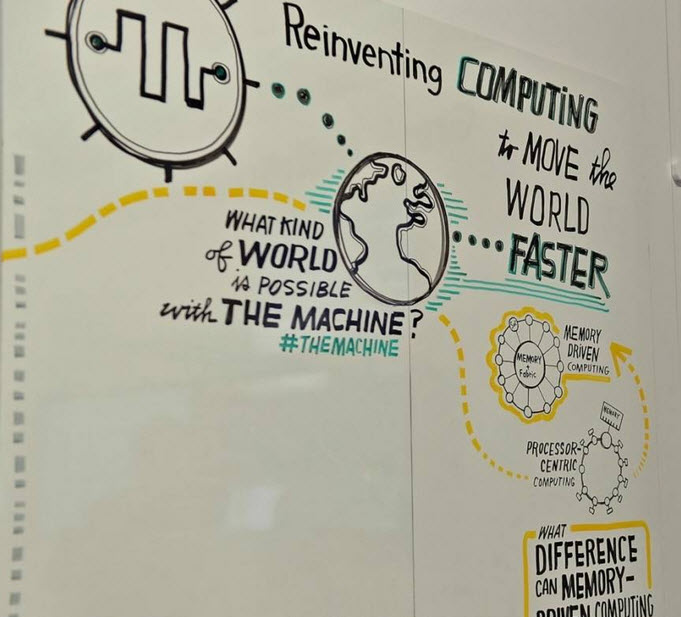

HPE dévoile l’ordinateur disposant de la taille mémoire centrale la plus importante du marché, et qui représente la dernière étape en date du projet de recherche The Machine. Il représente le programme R&D le plus important dans l’histoire de l’entreprise et a pour objectif de mettre en pratique un nouveau paradigme appelé Memory-Driven Computing, une architecture spécialement conçue pour l’ère du Big Data.

« Nous l’avons appelé The Machine, car les HP Labs n’ont pas de département marketing » expliquait alors avec une pointe d’humour Martin Fink, Directeur des HP Labs en présentant pour la première fois fin 2014 les travaux d’HP sur cette prochaine génération d’ordinateur (The Machine by HP). L’architecture de ce nouvel ordinateur est organisée sur d’un côté des processeurs spécialisée et de l’autres un pool de mémoire baptisée mémoire universelle connectés par une bus ultra rapide basé sur ces composants de type photonics. Cette architecture sera particulièrement adaptée pour traiter de très grands volumes de avec une consommation électrique largement réduite.

Des éléments avaient été donnés à l’occasion de la conférence Discover Londres 2016 (HPE : ordinateur orienté mémoire, systèmes hyperconvergés et mémoires flash) sur ce projet visant à développer un ordinateur orienté mémoire (Memory-Driven Computing) qui met la mémoire et non le traitement au centre des plates-formes informatiques. Le prototype présenté alors réunissait les caractéristiques suivantes :

– Un accès simultané à un pool de mémoires mutualisées par plusieurs nœuds de calcul ;

– Un système d’exploitation optimisé basé sur Linux fonctionnant sur un System on a Chip personnalisé (SOC) ;

– Des liens de communications optiques parmi le nouveau module photonique X1 ;

Sur la base du prototype actuel, HPE s’attend à ce que l’architecture puisse monter en puissance jusqu’à un système disposant d’un exaoctet de mémoire et, au-delà, vers un pool de mémoire presque illimité de 4 096 yottaoctets. Ce volume représente 250 000 fois la taille de la totalité de l’univers numérique connu à ce jour.

Avec une telle quantité d’espace mémoire, il sera possible de travailler simultanément sur chacune des données de santé numériques de chaque être humain, ou bien sur chaque donnée stockée sur Facebook, sur chaque trajet effectué par les véhicules autonomes de Google, ou encore sur chaque jeu de données issu de l’exploration spatiale, le tout en même temps. Ceci permettra d’obtenir des réponses et de découvrir de nouvelles opportunités avec une vitesse jamais imaginée.

Avec le Memory-Driven Computing, c’est la mémoire, et pas le processeur, qui est au centre de l’architecture informatique. En éliminant le manque d’efficacité avec lequel interagissent la mémoire, le stockage et les processeurs dans les systèmes traditionnels actuels, l’informatique pilotée par la mémoire réduit le temps nécessaire pour traiter des problèmes complexes, en passant de quelques jours à quelques secondes.

Parmi les principales caractéristiques du prototype présenté par HPE :

– Une taille de mémoire partagée de 160 To, répartie sur 40 nœuds physiques reliés avec un système d’interconnexion utilisant une haute performance.

– Un système d’exploitation basé sur Linux, fonctionnant sur le ThunderX2, un processeur double-socket de deuxième génération fabriqué par Cavium, capable de supporter des charges de travail ARMv8-A optimisées pour un System-on-a-Chip.

– Des liaisons de communication photoniques et optiques, utilisant par exemple le nouveau module photonique X1.

– Des outils de programmation logiciels, conçus pour tirer profit d’une mémoire persistante abondante.

– Des nouveaux outils logiciels de programmatique permettant de tirer parti d’une mémoire persistante massive. Pour certaines applications, HPE fait état d’une amélioration de performance jusqu’à 6000 fois supérieure que les systèmes traditionnels.

puis

puis